A pesar de los más de 50 ajustes de seguridad, privacidad y protección que TikTok dice tener para los adolescentes, la red social muestra una realidad diferente. Un experimento realizado por EL PAÍS con la cuenta de dos menores ficticios demuestra cómo, en pocos minutos, el algoritmo es capaz de abrir una vía de acceso a contenidos que normalizan la autolesión y el suicidio. La red social más usada por los adolescentes está fallando en su misión más crítica, según los expertos en salud mental consultados por este periódico: evitar que el sufrimiento psíquico se convierta en un bucle algorítmico sin salida.

EL PAÍS ha usado TikTok durante un día con las cuentas de Mario y Laura, dos menores ficticios de 13 y 15 años. Seis expertos en salud mental han analizado los contenidos a los que han tenido acceso. Su conclusión es alarmante: la red social pone en riesgo la salud y, en determinados casos, la vida de los menores. “No porque produzca automáticamente conductas en cualquier adolescente, sino porque aumenta la probabilidad de daño en quienes están en situación de vulnerabilidad y puede interferir con factores protectores clásicos, como pedir ayuda a un adulto”, afirma el psicólogo y psicoterapeuta Luis Fernando López-Martínez, profesor en la Universidad CEF-UDIMA y la Universidad Complutense de Madrid.

TikTok es la red social favorita de los jóvenes españoles. Así lo indica un informe de Qustodio, que destaca que la usan de media 115 minutos diarios. Otro estudio concluye que uno de cada cinco adolescentes de 12 a 18 años en España supera las dos horas al día en la aplicación. Según los autores, a mayor tiempo de uso, menor es su capacidad para poner límites y dejar la app.

La Comisión Europea ha declarado preliminarmente este viernes que TikTok infringe la Ley de Servicios Digitales (DSA) debido a su “diseño adictivo”. Según el organismo, funciones como el scroll infinito, la reproducción automática y un sistema de recomendación altamente personalizado “podrían perjudicar el bienestar físico y mental de sus usuarios, incluidos menores y adultos vulnerables”. Además, el control parental y las herramientas de gestión del tiempo de pantalla “no parecen reducir eficazmente los riesgos”. TikTok, que puede ejercer su derecho a la defensa, podría enfrentarse a una multa de hasta el 6% de su facturación anual (algo más de 10.000 millones de euros) si se confirman las conclusiones de la Comisión. Aunque la compañía ha indicado en un comunicado que la acusación es “falsa y totalmente infundada” y que tomará medidas para impugnarla.

Cuando el algoritmo refuerza el malestar

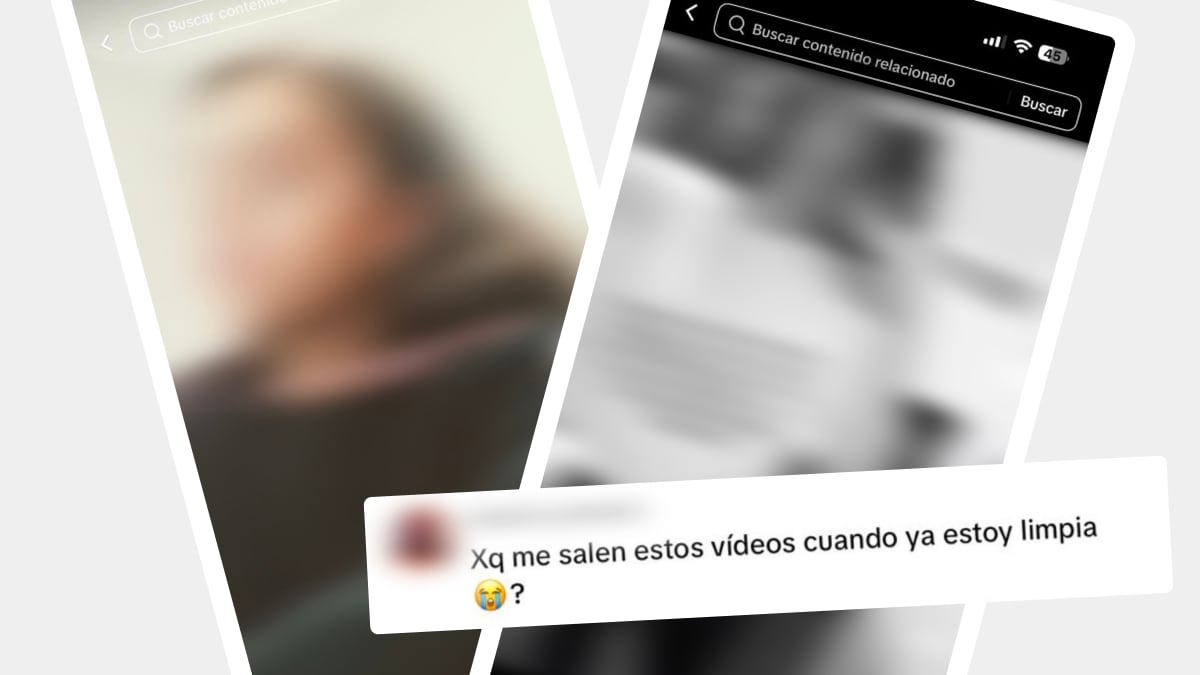

En el experimento realizado con cuentas de menores ficticios, bastaron pocas interacciones y búsquedas puntuales para que el algoritmo empezara a recomendar contenidos potencialmente perjudiciales para la salud. En cuestión de minutos, TikTok encadenó vídeos que banalizan el hecho de quitarse la vida y normalizan la autolesión. La pantalla se llenó de contenidos vinculados a conductas de riesgo y trastornos de la alimentación, así como de información detallada sobre cómo atentar contra la propia vida. EL PAÍS, tras ser asesorado por expertos en salud mental, ha decidido no incluir en este artículo enlaces a publicaciones ni referencias a conductas de autolesión o suicidio para garantizar la seguridad de los menores.

El problema no es hablar del malestar, sino cómo se hace. José González, psicólogo, formador y divulgador experto en procesos de duelo y prevención del suicidio, destaca que la exposición repetida a contenidos como los detectados en este experimento puede favorecer la imitación, convertir el sufrimiento en parte de la identidad y normalizar el daño. Destaca que algunos menores pueden pensar: “Si todos lo hacen, no debe ser tan grave”. Y entrar en un “túnel emocional” en el que parece que “todo el mundo está mal” y “esto no se va a pasar”.

Varias familias de Francia y Estados Unidos han demandado a TikTok acusándola de recomendar contenido sobre autolesiones y quitarse la vida a menores que fallecieron por suicidio. La plataforma afronta otras demandas, como la presentada en 2024 por una coalición de Estados en EE UU por el daño a la salud mental de los menores. Si bien las redes sociales pueden contribuir a la prevención del suicidio, algunas investigaciones destacan una asociación entre su uso adictivo y un mayor riesgo de conductas e ideación suicida.

Lo que le preocupa a Aurora Alés Portillo, enfermera especialista en salud mental y miembro de la Asociación de Enfermería de Salud Mental, es el funcionamiento del algoritmo: “Si muestras interés por algún tema que buscas por casualidad, eso hace que se te presente de forma repetitiva un contenido”. Esta repetición “monotemática” choca con la falta de madurez de la adolescencia temprana.

La validación de desconocidos sustituye el apoyo del círculo cercano, según la experta: “Todo el mundo puede hablarte sin que nadie sepa nada de tu vida”. En los comentarios analizados de la plataforma, muchos usuarios refuerzan comportamientos autolesivos. Entre la gran cantidad de contenidos potencialmente dañinos, se cuelan algunos que invitan a buscar apoyo profesional.

Riesgos para la salud

“Hay gente que quiere morirse porque se siente mal”, explica Maribel Gámez, psicóloga experta en inteligencia artificial y salud mental y coordinadora del grupo de psicología e IA del Colegio de la Psicología de Madrid. El suicidio es la tercera causa de defunción en las personas de 15 a 29 años, según la Organización Mundial de la Salud. Los datos de este organismo muestran que, aunque la tasa de suicidio sigue siendo más alta entre los chicos, las jóvenes de 15 a 19 años presentan la tasa más elevada en cuatro décadas.

Algunos usuarios de TikTok usan herramientas digitales no diseñadas para salud mental —y que en ningún caso sustituyen la ayuda especializada— para intentar controlar el malestar. Como señala Gámez, los menores entran en esta red buscando soluciones que la sociedad no les da. Lo que encuentran puede tener consecuencias en actos violentos o dañinos que el joven pueda estar considerando, según Ricardo Delgado Sánchez, coordinador nacional del grupo de trabajo de salud mental de la Sociedad Española de Medicina de Urgencias y Emergencias.

EL PAÍS ha hallado en TikTok trends virales relacionados con autolesiones y con quitarse la vida, además de ejemplos específicos muy alarmantes. Todo pese a que en sus normas la red social dice no permitir “el contenido que muestre o promueva el suicidio o la autolesión, o que ofrezca instrucciones para perpetrar dichos actos”. Al buscar en la plataforma palabras como “suicidio” o “autolesiones”, aparece este mensaje: “No estás solo/a. Si tú o alguien que conoces está pasando por un momento difícil, siempre hay ayuda disponible”, junto con el teléfono de la esperanza (+34 717 003 717), que brinda apoyo en situaciones de crisis.

Según ha indicado TikTok a EL PAÍS, “las cuentas de adolescentes tienen más de 50 ajustes de seguridad, privacidad y protección activados por defecto”, a los que se suman otros 20 que pueden gestionar los propios padres. Además, la compañía indica que si detecta un riesgo “inminente, creíble y específico”, “es posible” que contacte con los servicios de emergencia. Al preguntarle sobre algunos hallazgos específicos de esta investigación, la compañía dijo no poder contestar por “no tener toda la información de la cuenta”.

Entre julio y septiembre de 2025, TikTok eliminó 204,5 millones de vídeos de la plataforma, según su último informe sobre las normas comunitarias. Pero los usuarios tienen trucos para burlar la moderación de la red social. Usan términos alternativos a las palabras prohibidas y sus propios códigos. En las pruebas realizadas por este periódico, el propio buscador sugirió “alternativas” para encontrar contenido que en teoría está prohibido en la plataforma.

¿Hay menores de 13 años en TikTok?

La edad mínima para usar TikTok es de 13 años. Además de solicitar la edad al registrarse, TikTok afirma usar “tecnología” y capacitar a sus moderadores para identificar a menores de esa edad. De hecho, asegura eliminar alrededor de seis millones de cuentas de menores en todo el mundo cada mes. Pero la verificación de edad no es eficaz, según los expertos consultados. EL PAÍS ha detectado en la red social “cuentas secretas” de adolescentes y comentarios de usuarios que decían tener 12 años y preguntaban en un vídeo relacionado con la imagen corporal si su peso era “normal”.

Carmen Grau Del Valle, psicóloga en la Fundación para el Fomento de la Investigación Sanitaria y Biomédica de la Comunidad Valenciana y el Hospital Universitario Doctor Peset, destaca que los padres han normalizado que niños de 11 años tengan redes por miedo a que su hijo sea “el raro” del grupo: “Les estamos dando una herramienta con la que no se saben autorregular; tienen menor control de impulsos y una sensibilidad extrema a la recompensa inmediata”.

En este contexto, el Gobierno ha propuesto prohibir el acceso a las redes sociales a los menores de 16 años. Para López-Martínez, la medida es coherente, ya que “existe una exposición sistemática a un riesgo que afecta de forma desproporcionada a menores”. Pero el peligro no desaparece a los 16. Como señala el experto, la medida no será eficaz sin un control de edad efectivo y alfabetización emocional. Además, destaca el riesgo de que los menores vayan a espacios menos regulados.

Uso seguro de redes

El riesgo no es exclusivo de TikTok. Una investigación de EL PAÍS demostró que los controles de OpenAI para proteger la salud mental de los menores que usan ChatGPT no funcionan y otras plataformas tampoco están exentas de críticas. Los expertos aconsejan a los padres permitir el acceso de los menores a las redes de forma gradual y supervisada. López-Martínez es contundente: si no hay edad suficiente, no debe haber cuenta.

Para quienes ya están conectados, recomiendan priorizar el uso de dispositivos en zonas comunes, establecer límites claros y activar herramientas de control parental. También consideran fundamental enseñar a los menores a bloquear perfiles, silenciar palabras y reportar contenido que les haga sentir mal. La comunicación es clave, así como normalizar que en redes pueden aparecer contenidos dañinos.

López-Martínez advierte que castigar o retirar el móvil de forma brusca solo fomenta la ocultación. “Que en TikTok circulen vídeos para enseñar cómo ocultar aplicaciones a los padres es un indicador de una cultura de evitación para esquivar la supervisión adulta”, explica. El objetivo es crear un espacio seguro para hablar sin miedo y evitar que el algoritmo se convierta en el único “acompañante” en la angustia. Ante señales de alarma —como cambios de sueño o irritabilidad—, los expertos recomiendan buscar apoyo profesional.

TikTok en el punto de mira

Alés Portillo insiste en que no toda la responsabilidad puede recaer sobre los padres porque es “imposible” vigilar a los menores en todo momento. Los trabajadores de TikTok no tienen la obligación de buscar activamente vídeos como los detectados en esta investigación, según Samuel Parra, abogado especializado en tecnología informática. Sin embargo, la compañía sí debe actuar una vez que tiene conocimiento de su existencia: “Cuando se le reporta el contenido y no lo retira, puede tener responsabilidad legal”.

El presidente Pedro Sánchez ha anunciado que el Ejecutivo legislará para que los directivos de este tipo de plataformas tengan responsabilidad penal si no eliminan contenidos ilícitos. De confirmarse esta medida, según Parra, el CEO de TikTok o de cualquier red social podría tener que sentarse en un banquillo si hay indicios de que en su red se ha cometido alguno de los delitos que se quieren tipificar.

Para los expertos en salud mental consultados, TikTok ha creado un laberinto y debería ser responsable de lo que ocurre dentro. “Cuando la plataforma tiene capacidad de personalizar la exposición, también tiene la responsabilidad de demostrar que no está amplificando el riesgo en poblaciones vulnerables”, afirma López-Martínez. González coincide: “La libertad de expresión no puede justificar la exposición de menores a contenidos potencialmente letales”.

El teléfono 024 atiende a las personas con conductas suicidas y sus allegados. Las diferentes asociaciones de supervivientes tienen guías y protocolos de ayuda para el duelo. En caso de urgencia médica o compromiso vital, llama al 112.